VSCodeの拡張機能「Continue」とローカルLLM環境「Ollama」を連携して使う方法を、インストールから設定・動作確認までくわしく解説します。特にあなたが試した以下の設定内容を元に具体的な解説をします。

Continueとは

Continueは、VSCodeなどで動作するオープンソースのAIコードアシスタント拡張です。GitHub Copilotのように、AIモデルを使ったコード補完・チャット・コマンド生成を提供します。OllamaはローカルLLMの管理・実行ツールで、ContinueはVSCodeとOllamaの橋渡し役です。

Ollamaのインストール・モデル準備

- Ollama本体を公式サイトやコマンドでインストールします。

- 使用したいモデルを事前にOllamaでダウンロード(pull)します。

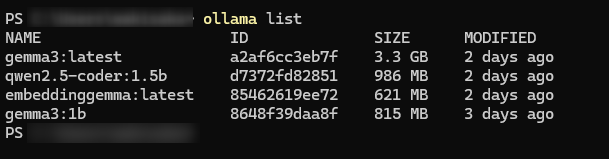

ollama listで導入済みモデルを確認します

Pullコマンドは以下

ollama pull gemma3:latest ollama pull qwen2.5-coder:1.5b ollama pull embeddinggemma:latest

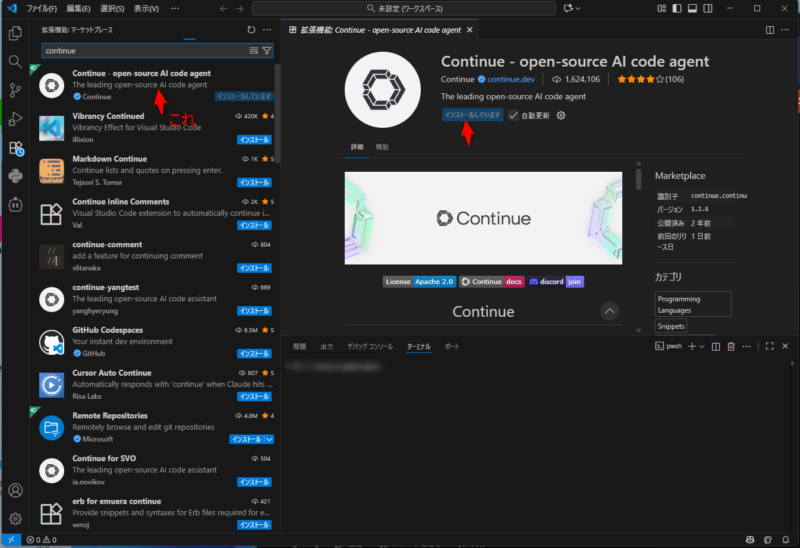

VSCodeでContinueのインストール

- VSCodeの拡張機能から「Continue」を検索してインストール。

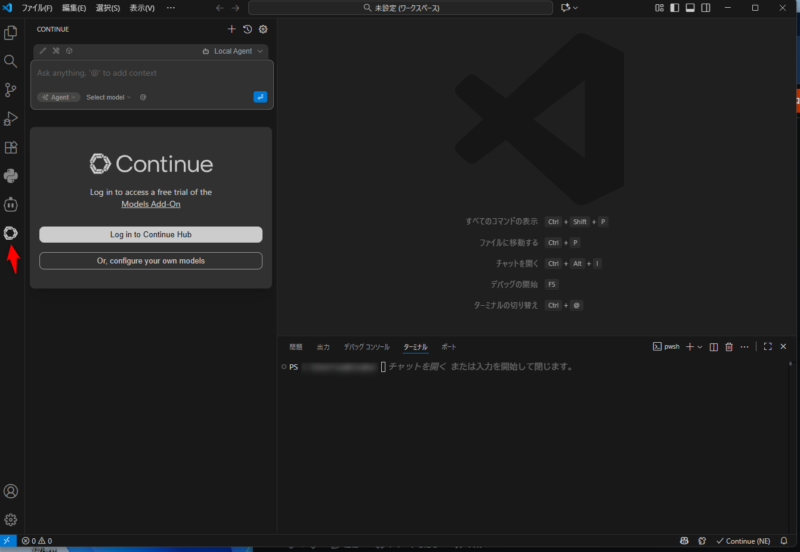

- インストール後、サイドバーにContinueアイコンが表示されれば完了。

config.yaml設定

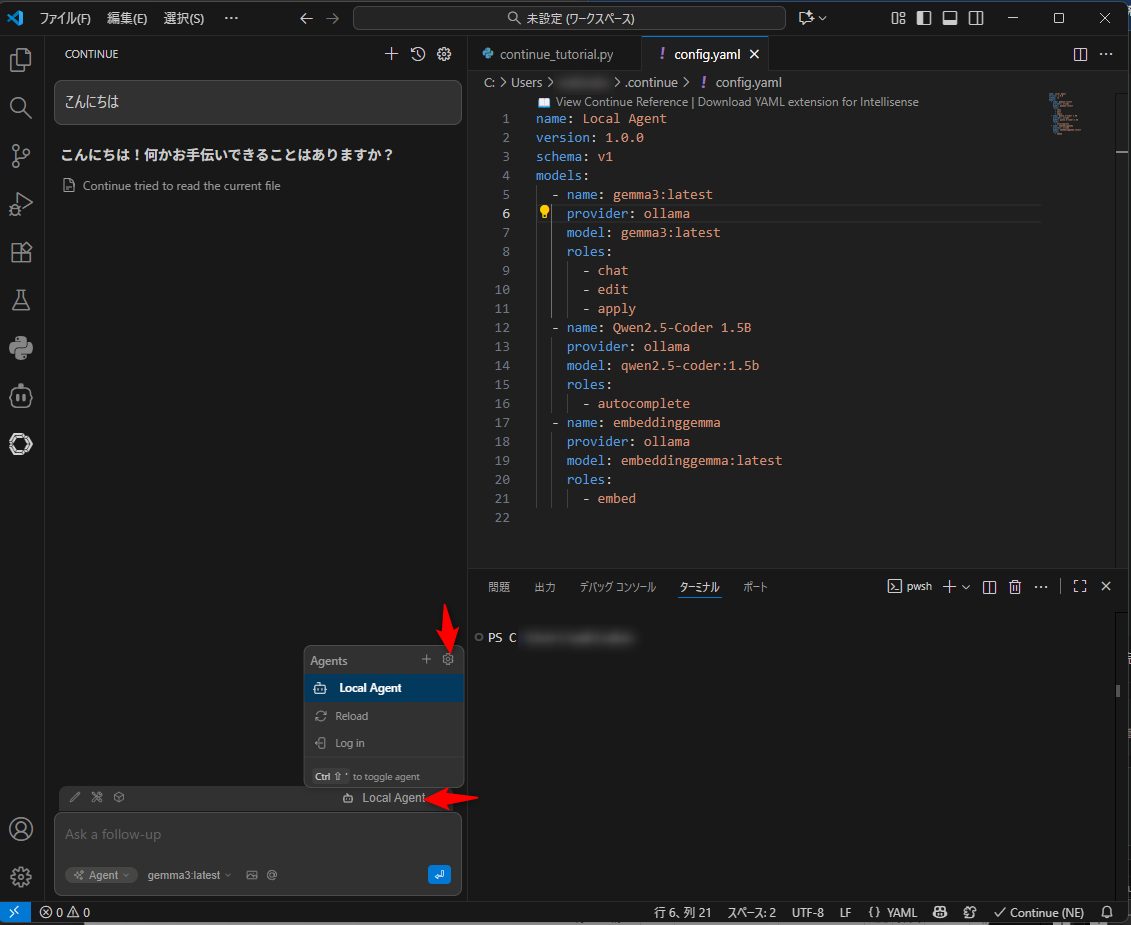

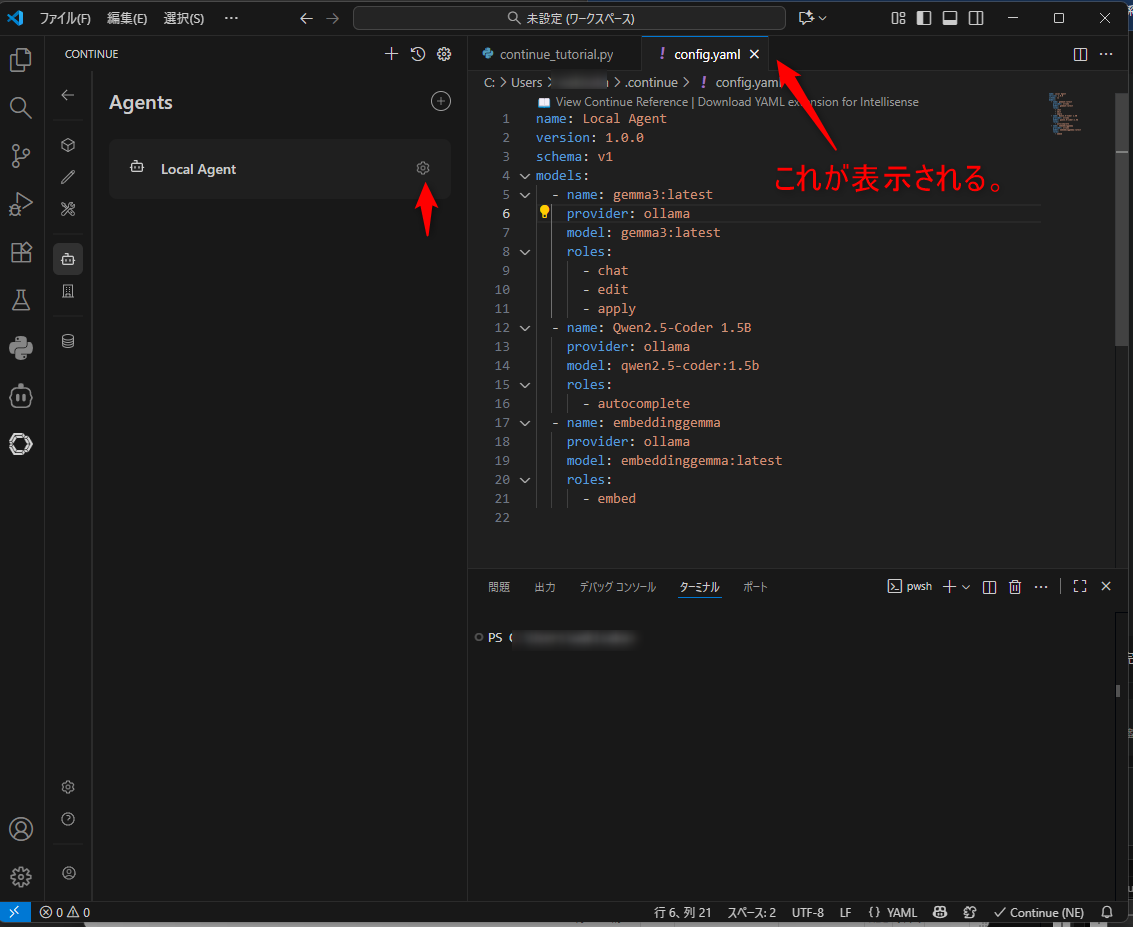

- LocalAgentをクリック

- 設定マークをクリック

- config.yamlが表示されるので、以下のような感じで自分の環境設定を入力

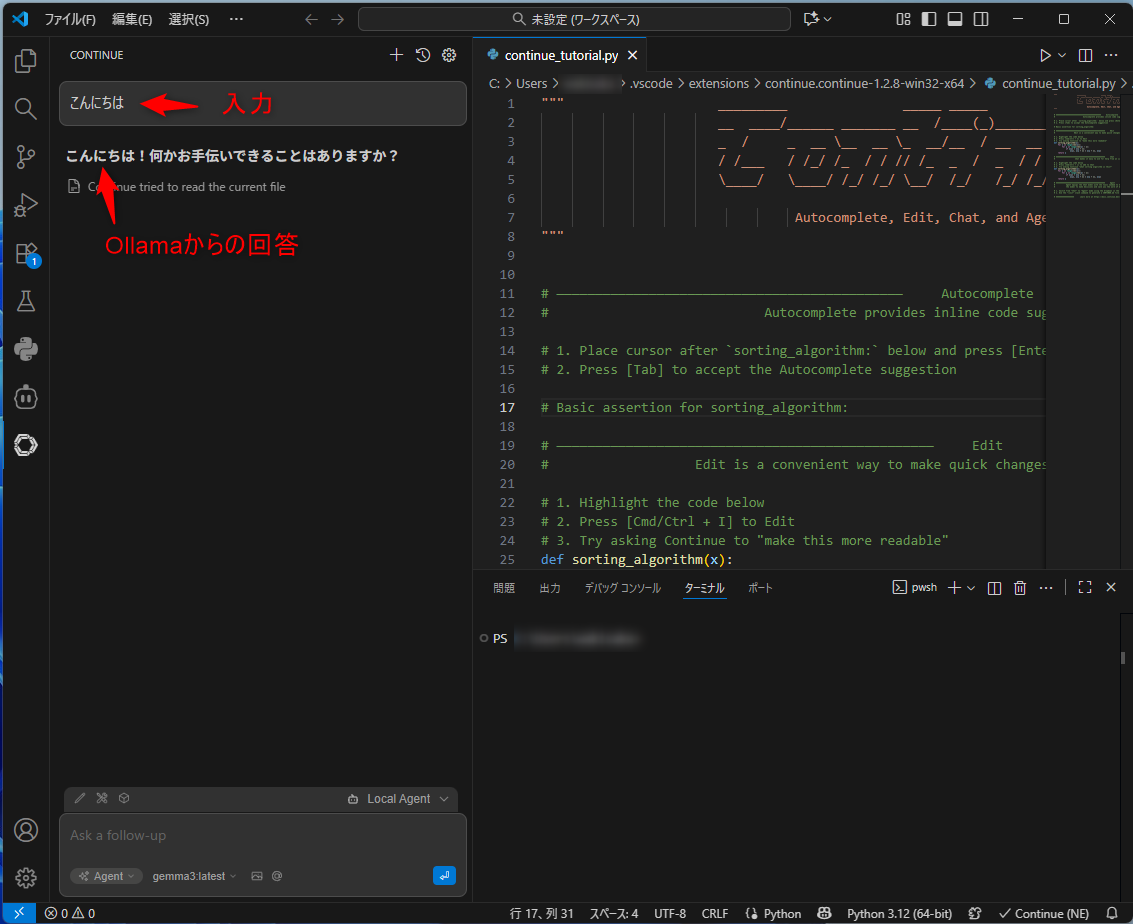

name: Local Agent

version: 1.0.0

schema: v1

models:

- name: gemma3:latest

provider: ollama

model: gemma3:latest

roles:

- chat

- edit

- apply

- name: Qwen2.5-Coder 1.5B

provider: ollama

model: qwen2.5-coder:1.5b

roles:

- autocomplete

- name: embeddinggemma

provider: ollama

model: embeddinggemma:latest

roles:

- embedname,version,schemaはメタ情報として任意に設定可能です。modelsには3種類のモデルを登録しています。- gemma3:latest: 会話やコード編集、適用用(chat/edit/apply)

- Qwen2.5-Coder 1.5B: コード補完用(autocomplete)

- embeddinggemma: 埋め込みベクトル生成用(embed)

- これにより、用途に応じたモデル切り替えがスムーズに行えます。

providerは必ずollamaを指定し、モデル名はOllamaで登録済みの完全一致名を使います。

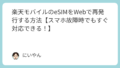

動作確認方法

- Ollamaを起動し、ブラウザから

http://localhost:11434/で「Ollama is running」を確認。 - VSCodeのContinue拡張を開き、モデル選択に各モデルが表示されているかチェック。

- 各モデルを選んでチャットやコード補完を試し、AIが応答すれば連携成功です。

トラブル対策と補足

- 設定が反映されない場合、

~/.continue/config.yamlの場所やフォーマットの誤りを確認。 - OllamaのListenポートを変更していたら

apiBaseパラメータを更新。 - Tab補完を使いたい場合は補完専用モデルの指定やContinueの設定を確認。

- VSCodeやOllamaの再起動は問題解決に効果的です。

- 大規模モデルはPCのメモリ容量も考慮してください。

まとめ

今回の設定で、VSCodeのContinue拡張はOllamaの複数モデル(会話用・補完用・埋め込み用)を有効活用できる環境が構築されます。

この環境はローカルで完結しプライバシー面でも安心、柔軟にモデルを切り替えながら快適なAIコーディングを支援します。

モデルの追加や設定の微調整は今後の運用で柔軟に行い、最適な開発環境を目指してください。

この内容を基に環境を整え、VSCode内でAIコードアシストを最大限活用しましょう.

コメント