Ollamaとは?

Ollamaは、ローカル環境で大規模言語モデル(LLM)を簡単に実行・管理できるAIツールです。コマンド一つでモデルの導入や切り替えができ、プライバシーやセキュリティ面でも安心して利用できるのが特徴です。

WSLとUbuntu 24.04の準備

まず、Windows 11上でWSL(Windows Subsystem for Linux)を使い、Ubuntu 24.04をインストールします。

PowerShellを管理者権限で開き、以下のコマンドを実行してください。

wsl --install -d Ubuntu-24.04インストール後、wslコマンドでUbuntu 24.04を起動します。

Ubuntu 24.04の初期設定

Ubuntuが起動したら、まずパッケージを最新に更新し、必要なツールを導入します。

sudo apt update

sudo apt upgrade

sudo apt install curlOllamaのインストール手順

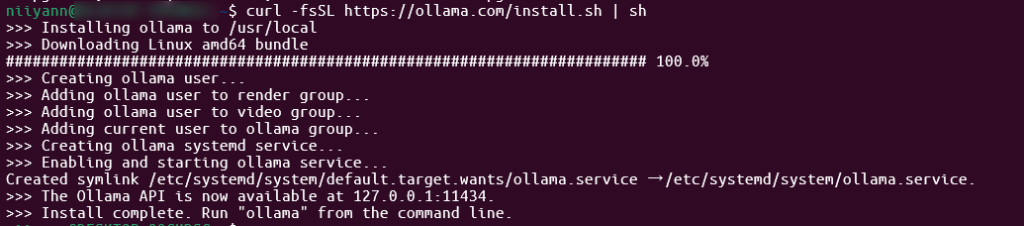

Ollama公式が提供しているインストールスクリプトを使えば、簡単に導入できます。

curl -fsSL https://ollama.com/install.sh | shこのコマンド一つでOllama本体と必要な依存パッケージが自動的にインストールされます。

注意点:

Ollamaはデフォルトで11434番ポートを使用します。Windows側でOllamaを同時に起動しているとポート競合が発生するため、WSL側またはWindows側のどちらか一方のみでOllamaを起動してください。

また、必要に応じてファイアウォールの設定を行い、11434番ポートを開放してください。

sudo apt install ufw

sudo ufw allow 11434/tcpインストール後の動作確認

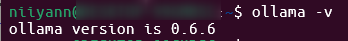

Ollamaのバージョンを確認して、正常にインストールされているかチェックします。

ollama -v以下のようにバージョンが表示されればOKです。

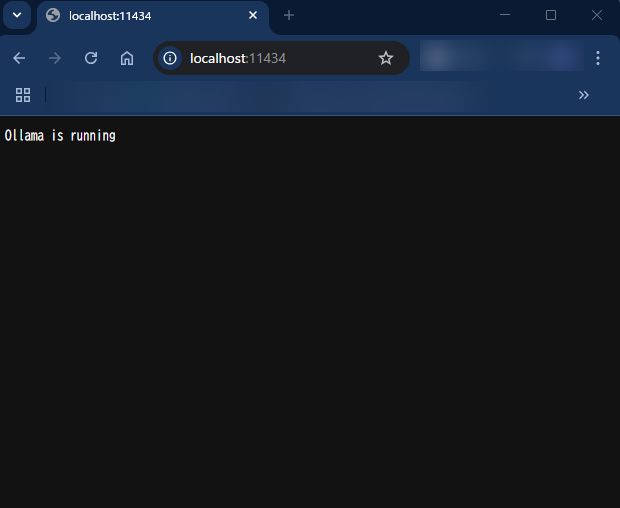

また、ブラウザで http://localhost:11434/ にアクセスし、「Ollama is running」と表示されればOKです。

GPUを利用したい場合:

NVIDIA GPUを使う場合は、Windows側に最新のNVIDIAドライバとCUDA on WSL2の設定が必要です。GPUを活用したい場合は、NVIDIA公式サイトやMicrosoftのWSL2ガイドも参考にしてください。

モデルの導入と実行例

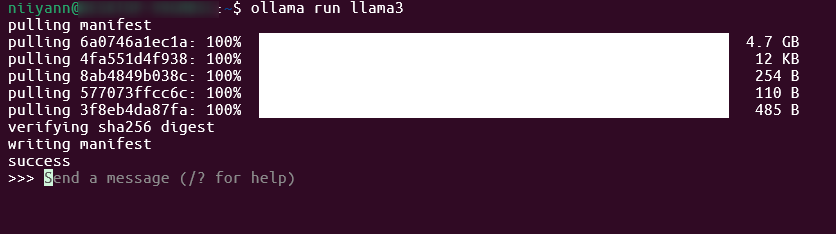

例えばLlama3モデルを導入して動かす場合は、以下のコマンドを実行します。

ollama run llama3モデルのダウンロードがはじまり、完了すると使用できるようになります。

まとめ

WSL(Ubuntu 24.04)環境でOllamaをインストールする手順はとてもシンプルです。

WSLとUbuntuのセットアップ後、公式スクリプトを実行するだけで、すぐにローカルで大規模言語モデルを扱えるようになります。

OllamaはAI開発や研究、個人利用にも最適なので、ぜひこの手順で導入してみてください。

WSL環境とホスト環境での速度比較してみたので、気になる方はこちら

コメント